© 2023 yanghn. All rights reserved. Powered by Obsidian

6.2 图像卷积

要点

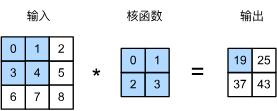

1. 互相关运算

严格来说,卷积层是个错误的叫法,因为它所表达的运算其实是_互相关运算_(cross-correlation),而不是卷积运算。

- 不管哪个位置,核是不变的(平移不变性)

- 核矩阵的大小远小于输入矩阵的大小(局部性)(参考[[6.1 从全连接到卷积]])

下面代码实现互相关运算:

import torch

from torch import nn

from d2l import torch as d2l

def corr2d(X, K): #@save

"""计算二维互相关运算"""

h, w = K.shape

Y = torch.zeros((X.shape[0] - h + 1, X.shape[1] - w + 1))

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

Y[i, j] = (X[i:i + h, j:j + w] * K).sum() # 直接运用矩阵元素乘法

return Y

2. 卷积层

对于二维矩阵,卷积层如下定义:

- 输入

- 核

- 偏差

- 输出

和 是可学习的参数

# 卷积层

class Conv2D(nn.Module):

def __init__(self, kernel_size):

super().__init__()

self.weight = nn.Parameter(torch.rand(kernel_size))

self.bias = nn.Parameter(torch.zeros(1))

def forward(self, x):

return corr2d(x, self.weight) + self.bias

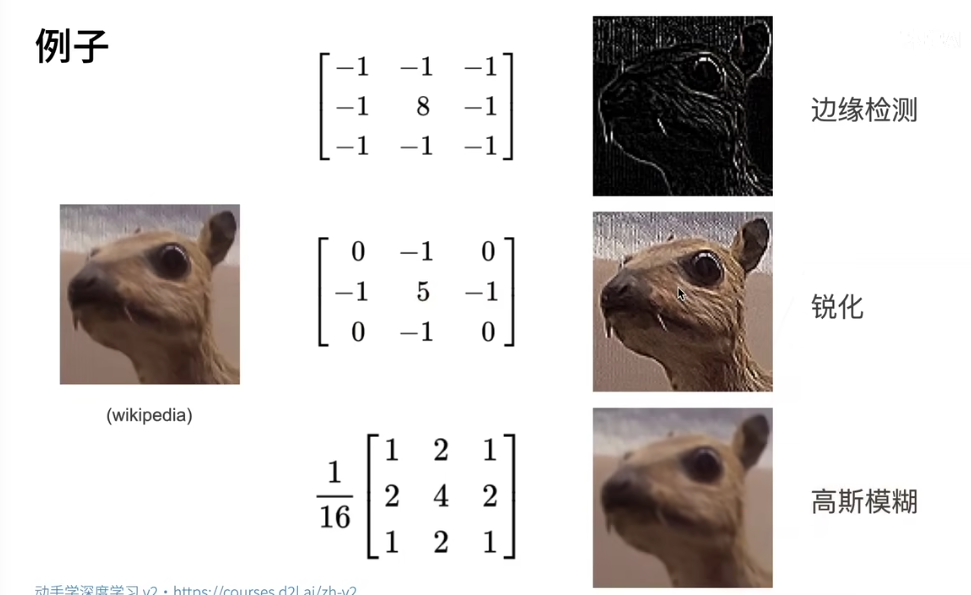

3. 边缘检测简单应用

假设我们有个这样的图像:

X = torch.ones((6, 8))

X[:, 2:6] = 0

X

tensor([[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.],

[1., 1., 0., 0., 0., 0., 1., 1.]])

我们希望检测出这个图像的边缘,这种核应该是

K = torch.tensor([[1.0, -1.0]]) #进行互相关运算时,如果水平相邻的两元素相同,则输出为零,否则输出为非零。

检测出来的边缘为:

Y = corr2d(X, K)

Y

现在我们想要学习我们定义的核 K,已知 X 和 Y 的情况下:

# 构造一个二维卷积层,它具有1个输出通道和形状为(1,2)的卷积核

conv2d = nn.Conv2d(1,1, kernel_size=(1, 2), bias=False)

# 这个二维卷积层使用四维输入和输出格式(批量大小、通道、高度、宽度),

# 其中批量大小和通道数都为1

X = X.reshape((1, 1, 6, 8))

Y = Y.reshape((1, 1, 6, 7))

lr = 3e-2 # 学习率

for i in range(10):

Y_hat = conv2d(X)

l = (Y_hat - Y) ** 2

conv2d.zero_grad()

l.sum().backward()

# 迭代卷积核

conv2d.weight.data[:] -= lr * conv2d.weight.grad

if (i + 1) % 2 == 0:

print(f'epoch {i+1}, loss {l.sum():.3f}')

epoch 2, loss 6.422

epoch 4, loss 1.225

epoch 6, loss 0.266

epoch 8, loss 0.070

epoch 10, loss 0.022

- 第 2 行:利用内置的卷积层,从左到右分别表示输出通道和输入通道,参考 [[6.4 多输入多输出通道]],自己定义的卷积层只能计算二维矩阵,不能用通道的概念

- 第 16 行:手动实现梯度下降

conv2d.weight.data.reshape((1, 2))

# tensor([[ 1.0010, -0.9739]]) 和定义的 K 非常接近